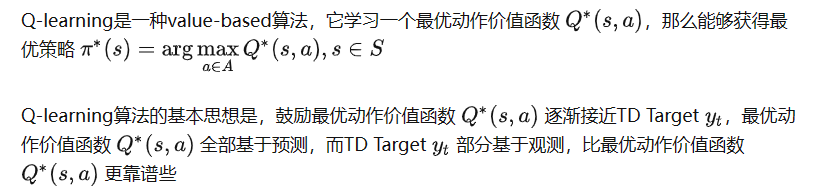

Q-learning 算法

遗传算法计算数学 中用于解决最优化 的搜索算法 ,是进化算法 的一种。计算机模拟 。对于一个最优化问题,一定数量的候选解 (称为个体)可抽象表示为染色体 ,使种群 向更好的解进化。传统上,解用二进制 表示(即0和1的串),但也可以用其他表示方法。进化从完全随机 个体的种群开始,之后一代一代发生。在每一代中评价整个种群的适应度 ,从当前种群中随机地选择多个个体(基于它们的适应度),通过自然选择和突变产生新的生命种群,该种群在算法的下一次迭代中成为当前种群。

精英保留

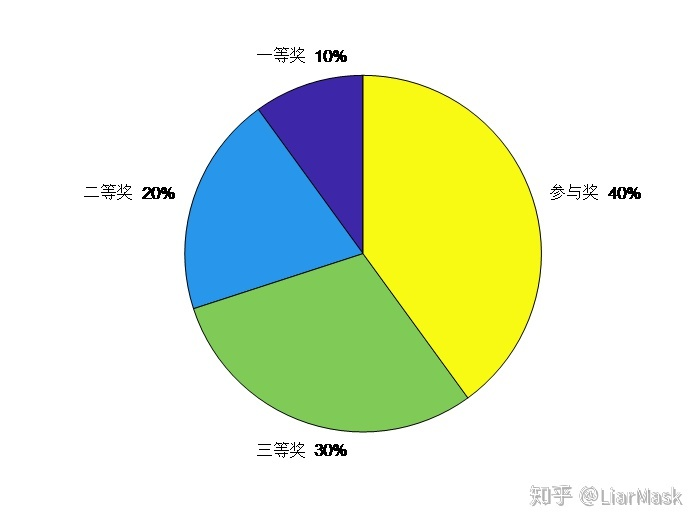

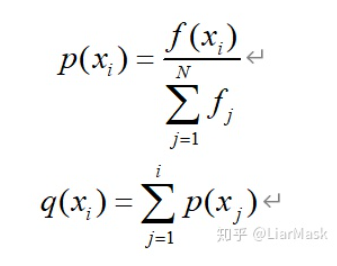

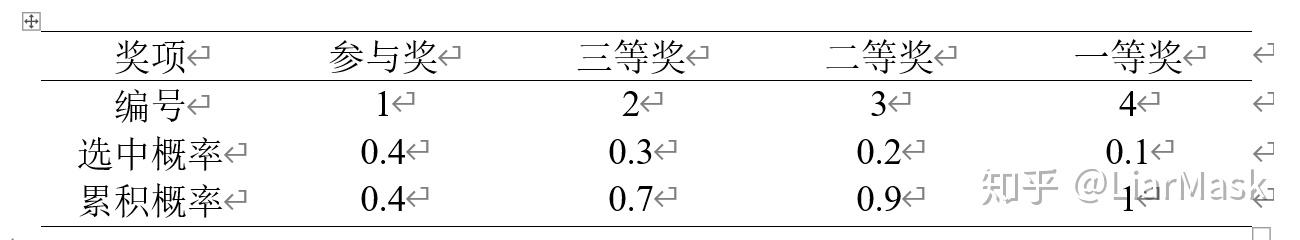

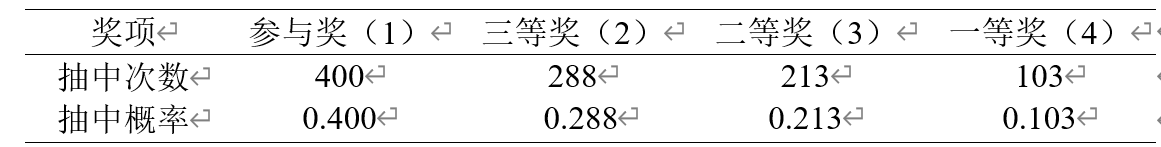

轮盘赌这难道不会导致某些个体明明选中概率很小但却因为它位置靠后而导致其累积概率很大而被选中的情况发生吗?显然这与轮盘赌选择法的初衷是矛盾的啊!